Những cảnh báo về mối nguy AI có thể bị "vũ khí hóa"

Đây là phát biểu của Chủ tịch Microsoft - Brad Smith trong một cuộc trả lời phỏng vấn với CNBC vào cuối tháng 8 vừa qua.

Microsoft là một trong những công ty dẫn đầu về trí tuệ nhân tạo và đầu tư sớm vào OpenAI. Hãng cũng đưa AI vào công cụ tìm kiếm Bing, đồng thời chi hàng tỷ USD để nghiên cứu các ứng dụng về trí tuệ nhân tạo khác.

Smith cho biết Microsoft nhận thức được rủi ro tiềm ẩn liên quan đến việc sử dụng AI, đồng thời vận động các công ty khác "làm điều đúng đắn". Ông cũng ủng hộ các quốc gia ra luật và quy định mới nhằm đảm bảo các giao thức an toàn được tuân thủ.

"Hãy tưởng tượng, nguồn điện phụ thuộc vào cầu dao, xe bus có phanh khẩn cấp", ông ví von. "Chúng ta đã có cách kiểm soát tương tự với các công nghệ khác. Bây giờ cũng nên áp dụng cho AI".

|

| Một siêu máy tính trí tuệ nhân tạo ở California, Mỹ. (Ảnh: Reuters) |

Trước Smith, nhiều lãnh đạo công nghệ, chính khách cũng bày tỏ lo ngại AI có thể bị biến thành vũ khí hủy diệt.

Tại buổi lễ tốt nghiệp của Học viện Không quân Mỹ vào đầu tháng 8/2023, Tổng thống Mỹ Joe Biden cảnh báo về sức mạnh của trí tuệ nhân tạo (AI), dự đoán công nghệ này có thể "vượt qua suy nghĩ của con người" trong một tương lai không xa. "Sẽ không dễ dàng gì. Đây là cơ hội đáng kinh ngạc, nhưng chúng ta có rất nhiều việc phải giải quyết", ông Biden phát biểu.

Hồi tháng 5/2023, Geoffrey Hinton, một trong những người tiên phong về AI rời Google để cảnh báo những mối nguy từ công nghệ này. Sam Altman, CEO OpenAI - công ty đứng sau ChatGPT, cũng nói nỗi sợ lớn nhất với AI là nó có thể gây hại cho thế giới nếu không kiểm soát. Elon Musk cũng cho rằng AI có thể trở thành vũ khí gây nên "sự kết thúc của nhân loại".

Kiểm soát thế nào?

Tháng 3/2023, hơn 1.100 chuyên gia công nghệ và nhà nghiên cứu nổi tiếng đã ký vào thư ngỏ kêu gọi Liên hợp quốc và các tổ chức quốc tế kiểm soát chặt chẽ, đảm bảo an toàn và đạo đức trong phát triển AI. Đồng thời tăng cường hợp tác quốc tế để đảm bảo công nghệ AI được sử dụng có ích cho con người và xã hội. Thư có sự tham gia của Elon Musk, nhà đồng sáng lập Apple Steve Wozniak, CEO Stability AI Emad Mostaque và người được mệnh danh là "bố già AI" Yoshua Bengio.

Trong thư, các chuyên gia công nghệ đã đề xuất một số biện pháp cụ thể để kiểm soát AI, bao gồm:

Kiểm soát độ tin cậy của hệ thống: AI cần được thiết kế và phát triển để đảm bảo tính an toàn và độ tin cậy thông qua các phương pháp kiểm tra chất lượng, kiểm soát, và giám sát chặt chẽ, thường xuyên, liên tục để đảm bảo hệ thống AI hoạt động theo mong muốn của con người và tránh những tác động không mong muốn từ độ thiếu tin cậy của nó.

Công nghệ trí tuệ nhân tạo cần phải được lập trình để hoạt động theo các giá trị đạo đức và chuẩn mực xã hội. Các quy định và tiêu chuẩn đó cần phải được thiết lập một cách rõ ràng và phải được giám sát thực hiện để đảm bảo rằng chúng không làm bất kỳ việc gì xấu hay có hại cho con người hoặc tổ chức. Quy trình phân tích, đánh giá tác động và giám sát hoạt động của hệ thống AI cũng phải được thường xuyên thực hiện để đảm bảo hoạt động chuẩn mực, không vi phạm và làm xói mòn các giá trị chung của toàn xã hội, không gây ra tác động tiêu cực và đảm bảo truyền tải kiến thức và giá trị đúng đắn.

Tạm dừng “huấn luyện” trong ít nhất 6 tháng đối với các hệ thống trí tuệ nhân tạo để đánh giá lại toàn bộ vấn đề. Việc tạm dừng này phải được công khai, có kiểm soát và tất cả các nhân tố chính liên quan đến việc đào tạo này đều phải thực hiện. Nếu cần thiết, các chính phủ cần ban hành lệnh cấm tạm thời. Điều này không có nghĩa là dừng phát triển AI hoàn toàn mà chỉ đơn thuần là một lần tạm dừng trong cuộc đua nguy hiểm để chuyển sang các mô hình phát triển khác, làm cho các hệ thống AI trở nên chính xác, an toàn, dễ hiểu, minh bạch, phù hợp, đáng tin cậy và trung thành hơn. Đây là một giải pháp tổng thể mà Elon Musk và các đồng nghiệp kêu gọi trong thư ngỏ nhưng tính khả thi là không cao. Rất khó để tất cả các phòng thí nghiệm độc lập tuân thủ một kêu gọi không có tính ràng buộc mà lại có tính xuyên quốc gia như vậy.

Tăng cường hợp tác và chia sẻ thông tin giữa các quốc gia, tổ chức nghiên cứu AI độc lập để đảm bảo rằng AI được phát triển và sử dụng một cách an toàn trong tương lai. Hợp tác và chia sẻ thông tin cũng là biện pháp để kịp thời cảnh báo và ngăn chặn bất kỳ nguy cơ nào nổi lên trong tương lai.

Tin bài liên quan

Trí thức, doanh nghiệp Việt Nam tại châu Âu bàn giải pháp tăng cường hợp tác khoa học - công nghệ với EU

Dự thảo Luật Trí tuệ nhân tạo: Hướng tới khuôn khổ pháp lý linh hoạt, đồng bộ và khả thi

Trí tuệ nhân tạo cần một trái tim

Các tin bài khác

Nhiều nước kêu gọi công dân rời Iran và Israel ngay lập tức

Thị trường tài chính Mỹ và toàn cầu phản ứng mạnh sau các tuyên bố từ Tổng thống Trump

Tổng thống Trump ký sắc lệnh áp thuế toàn cầu 10% sau phán quyết của Tòa án Tối cao

Chính quyền Saint Petersburg tổ chức hội thảo về kết quả Đại hội XIV của Đảng

Đọc nhiều

Đỗ Như Tuấn – doanh nhân Việt tại Nhật với nhiều hoạt động vì cộng đồng

Quảng bá di sản áo dài Việt Nam tại Lào

Cần Thơ tăng cường hợp tác với Pháp trên các lĩnh vực giáo dục, y tế

Tiến sĩ Michael Parsons (Australia): Ngày bầu cử ở Việt Nam mang không khí lễ hội

Bờ cõi biển đảo

Miền đất - Con người Cuộc sống vùng biên Nhịp sống biển đảo Lịch sử chủ quyền Giao lưu hữu nghị

Đổi mới chương trình Giao lưu hữu nghị quốc phòng biên giới Việt Nam-Trung Quốc

Ninh Bình siết quản lý tàu cá, chuẩn bị làm việc với Đoàn Thanh tra EC lần thứ 5

Tàu 016-Quang Trung vượt qua đường xích đạo tham dự Kakadu (2026)

Multimedia

[Infographic] Bầu cử Quốc hội và HĐND: Cách tra cứu thông tin về người ứng cử trên VNeID

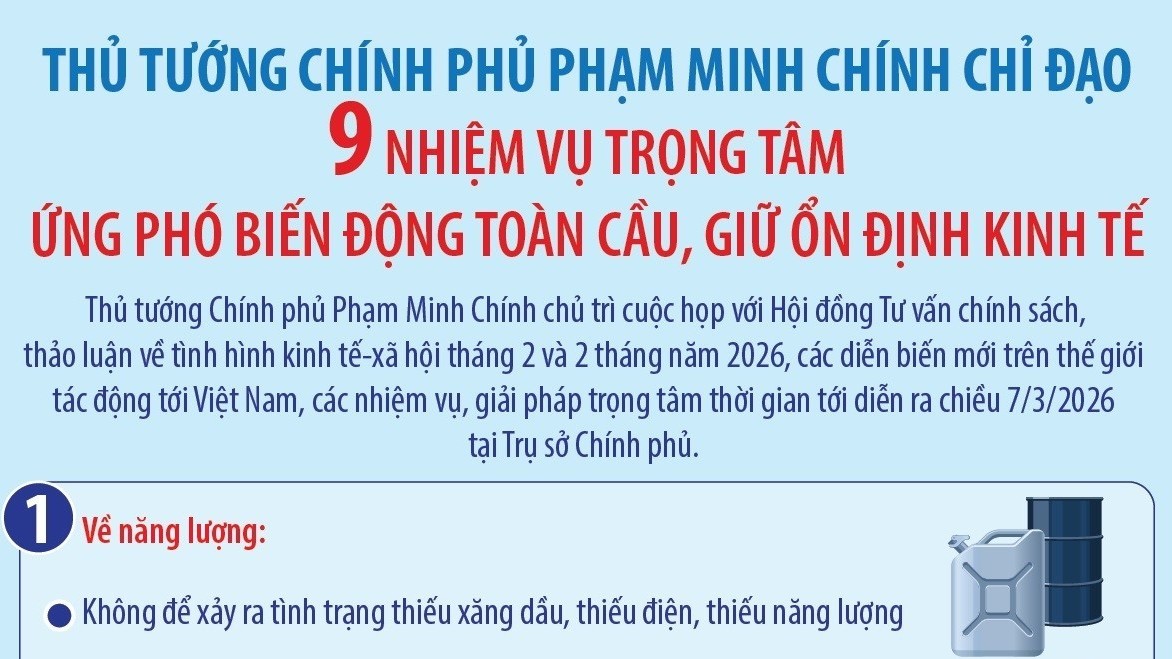

[Infographic] Thủ tướng chỉ đạo 9 nhiệm vụ trọng tâm ứng phó biến động toàn cầu

[Infographic] Đến năm 2030, phấn đấu thu nhập bình quân người dân nông thôn tăng gấp 2,5-3 lần so với năm 2020

[Infographic] 4 mốc thời gian của 4 kỷ nguyên quan trọng trong 100 năm Đảng lãnh đạo

[Infographic] 5 điểm then chốt có ý nghĩa quyết định trong tổ chức thực hiện Nghị quyết Đại hội XIV của Đảng

[Infographic] Nghị quyết số 68-NQ/TW tác động sâu rộng tới toàn bộ nền kinh tế

[Infographic] Những Nghị quyết chiến lược đưa Việt Nam bước vào kỷ nguyên mới

Đại sứ Lào tại Việt Nam tin tưởng Đại hội XIV sẽ tạo động lực mạnh mẽ cho Việt Nam phát triển toàn diện

Tổ chức Giao lưu Quốc tế Việt Nam Nhật Bản (FAVIJA): thúc đẩy hữu nghị, hợp tác đa phương

![[Video] Vũ điệu chúc xuân sôi động của Đại sứ Hà Lan tại Việt Nam](https://thoidai.com.vn/stores/news_dataimages/2026/022026/13/06/croped/video-dai-su-ha-lan-tai-viet-nam-gui-loi-chuc-tet-bang-vu-dieu-soi-dong-20260213062706.jpg?260213053058)

[Video] Vũ điệu chúc xuân sôi động của Đại sứ Hà Lan tại Việt Nam

![[Video] Đại sứ Lào tại Việt Nam tin tưởng Đại hội XIV sẽ tạo động lực mạnh mẽ cho Việt Nam phát triển toàn diện](https://thoidai.com.vn/stores/news_dataimages/2026/012026/19/10/video-dai-su-lao-tai-viet-nam-tin-tuong-dai-hoi-xiv-se-tao-dong-luc-manh-me-cho-viet-nam-phat-trien-toan-dien-20260119100621.jpg?rt=20260119100624?260119015548)

[Video] Đại sứ Lào tại Việt Nam tin tưởng Đại hội XIV sẽ tạo động lực mạnh mẽ cho Việt Nam phát triển toàn diện

![[Video] WVIV thúc đẩy nông nghiệp tái sinh, nâng cao sinh kế cộng đồng tại Thanh Hóa](https://thoidai.com.vn/stores/news_dataimages/2026/012026/25/12/video-wviv-thuc-day-nong-nghiep-tai-sinh-nang-cao-sinh-ke-cong-dong-tai-thanh-hoa-20260125121019.jpg?rt=20260125121023?260126090118)

[Video] WVIV thúc đẩy nông nghiệp tái sinh, nâng cao sinh kế cộng đồng tại Thanh Hóa

![[Video] Plan International và Tỉnh Đoàn Quảng Trị xây dựng lực lượng thanh niên hành động vì khí hậu](https://thoidai.com.vn/stores/news_dataimages/2026/012026/25/12/plan-international-va-tinh-doan-quang-tri-xay-dung-luc-luong-thanh-nien-hanh-dong-vi-khi-hau-20260125120627.jpg?rt=20260125120631?260126090029)

[Video] Plan International và Tỉnh Đoàn Quảng Trị xây dựng lực lượng thanh niên hành động vì khí hậu

![[Video] 10 sự kiện văn hóa, thể thao và du lịch tiêu biểu năm 2025](https://thoidai.com.vn/stores/news_dataimages/anhvm/012026/06/17/10_SUYY_KIEYYN_VAYN_HOAY_THEYY_THAO_VAY_DU_LIYCH_TIEYU_BIEYYU_NAYM_2025_mp4_29_12_-_YouTube_11.jpg?260106064252)

[Video] 10 sự kiện văn hóa, thể thao và du lịch tiêu biểu năm 2025

Plan International Việt Nam hỗ trợ khẩn cấp hơn 1,8 tỷ đồng cho người dân Đà Nẵng sau bão

Vietnam Happy Fest 2025: Lan tỏa những giá trị hạnh phúc giữa lòng Hà Nội

![[VIDEO] Tổ chức Cứu trợ Trẻ em tiếp sức trẻ em Bắc Ninh sớm quay về nhịp sống sau thiên tai](https://thoidai.com.vn/stores/news_dataimages/2025/122025/06/13/croped/cu-u-tro-bn-2-cover20251206131142.jpg?251206015430)

[VIDEO] Tổ chức Cứu trợ Trẻ em tiếp sức trẻ em Bắc Ninh sớm quay về nhịp sống sau thiên tai

![[Video] World Vision hỗ trợ hơn 1.100 người dân Quảng Ngãi tiếp cận nước sạch bền vững](https://thoidai.com.vn/stores/news_dataimages/2025/112025/25/09/dong-tam-doc-suc-cuu-tro-dong-bao-vung-lu-20251125093203.jpg?rt=20251125093457?251125104340)

[Video] World Vision hỗ trợ hơn 1.100 người dân Quảng Ngãi tiếp cận nước sạch bền vững

![[Video] Đồng tâm, dốc sức cứu trợ đồng bào vùng lũ](https://thoidai.com.vn/stores/news_dataimages/2025/112025/25/09/dong-tam-doc-suc-cuu-tro-dong-bao-vung-lu-20251125093208.jpg?rt=20251125093211?251125103933)

[Video] Đồng tâm, dốc sức cứu trợ đồng bào vùng lũ

![[Video] Ấn Độ tặng Giải thưởng Hòa bình Romesh Chandra cho bà Nguyễn Thị Bình](https://thoidai.com.vn/stores/news_dataimages/2025/112025/18/18/croped/ba-bi-nh-cover20251118184907.jpg?251119023755)

[Video] Ấn Độ tặng Giải thưởng Hòa bình Romesh Chandra cho bà Nguyễn Thị Bình

![[Video] Lễ dâng y Kathina tại Đà Nẵng: Sợi dây gắn kết Phật giáo các nước châu Á](https://thoidai.com.vn/stores/news_dataimages/anhvm/102025/15/11/Kathina__1.jpg?251015023951)

[Video] Lễ dâng y Kathina tại Đà Nẵng: Sợi dây gắn kết Phật giáo các nước châu Á

Cả nước hướng về Thái Nguyên: Chung tay giúp người dân vượt qua mưa lũ

Trailer lễ hội Văn hóa Thế giới tại Hà Nội lần thứ nhất

Thời tiết hôm nay (11/3): Miền Bắc rét về đêm và sáng, ngày nắng

Nắm rõ quy định để lá phiếu hợp lệ trong ngày bầu cử 15/3

39 suất học bổng toàn phần tại New Zealand

Bầu cử Quốc hội và Hội đồng Nhân dân: Những điều cần biết về cử tri

Thời tiết hôm nay (3/3): Gió Đông Bắc về, miền Bắc trở lạnh 15 độ C