Trí tuệ nhân tạo có thể xâm phạm quyền con người?

Ý kiến trên được ông Pichai đưa ra trong cuộc trả lời phỏng vấn báo Washington Post của Mỹ ngày 12/12. Theo đó, đại diện của Google nhấn mạnh: Các công ty công nghệ xây dựng AI nên tính tới khía cạnh đạo đức ngay từ ban đầu khi bắt tay vào tiến trình này, để chắc chắn rằng AI với "công dụng của riêng mình" không làm tổn hại tới con người.

Trước đó, hồi tháng 6 năm nay, Google đã công bố một bộ quy tắc AI nội bộ. Trong đó, quy tắc đầu tiên là AI cần có ích cho xã hội. Google cam kết không thiết kế hoặc phát triển AI sử dụng làm vũ khí, giám sát vượt ngoài các quy tắc quốc tế, hoặc liên quan tới công nghệ nhằm xâm phạm quyền con người.

Trong nỗ lực phát triển công nghệ AI, Google cũng lên kế hoạch tiếp tục phối hợp với quân đội và các chính phủ trong các lĩnh vực an ninh mạng, đào tạo, tuyển dụng nhân sự, chăm sóc sức khỏe, cũng như tìm kiếm, cứu nạn.

|

Giám đốc Google, ông Sundar Pichai. Ảnh: BBC.

Google hiện đi đầu thế giới về phát triển AI và đang cạnh tranh trong lĩnh vực phần mềm thông minh với các "ông lớn công nghệ" khác như Amazon, Apple, Microsoft, IBM và Facebook.

Hiện nay, AI đang được sử dụng để nhận diện người trong các bức ảnh, lọc những nội dung không phù hợp khỏi các nền tảng mạng trực tuyến và kích hoạt các phương tiện ô tô tự lái. Tiến bộ của AI là không thể phủ nhận, tuy nhiên những năng lực ngày càng gia tăng của AI đang gây nhiều tranh cãi về những tác động đến xã hội và đạo đức...

Trong quá khứ, nhà khoa học nổi tiếng Stephen Hawking từng nhận định việc tạo ra AI thành công có thể là sự kiện tuyệt vời nhất trong lịch sử nền văn minh, nhưng nếu xã hội không tìm cách kiểm soát sự phát triển của nó, AI cũng có thể là "sự kiện tồi tệ nhất".

Nhà khoa học người Mỹ khi đó đưa ra cảnh báo giật mình: Khi vượt ngoài tầm kiểm soát, AI có thể thành một loại vũ khí tự trị mạnh mẽ hoặc biến đổi thành công cụ mới để người áp bức người nhiều hơn, gây ra sự gián đoạn lớn đối với nền kinh tế.

Hoàng Nam

Tin bài liên quan

Các tin bài khác

Thông báo về điện mừng Đại hội XIV của Đảng

Đại hội XIV tạo xung lực mới cho Việt Nam phát triển và hội nhập

Đại hội XIV của Đảng Cộng sản Việt Nam qua góc nhìn của bạn bè quốc tế

Chuyên gia Hàn Quốc kỳ vọng về bước ngoặt phát triển bền vững của Việt Nam

Đọc nhiều

New Zealand trao hơn 4,7 tỷ đồng ủng hộ Lạng Sơn sau bão lũ

Giao lưu văn hóa Việt - Hàn 2026: Nhịp cầu kết nối tình dân hai nước

Tổng Bí thư, Chủ tịch nước Lào đánh giá cao vai trò của Mặt trận trong quan hệ Việt Nam - Lào

Học sinh Hoa Kỳ tìm hiểu lịch sử, văn hóa Việt Nam qua giao lưu thanh niên

Bờ cõi biển đảo

Miền đất - Con người Cuộc sống vùng biên Nhịp sống biển đảo Lịch sử chủ quyền Giao lưu hữu nghị

Thủ tướng yêu cầu quyết tâm gỡ “thẻ vàng” IUU trong tháng 4/2026

EU ghi nhận nỗ lực gỡ “thẻ vàng” IUU của Việt Nam, kỳ vọng EC sớm thanh tra thực địa

Nghị định mới hướng dẫn thi hành Luật Thủy sản: Siết quản lý tàu cá và chống khai thác IUU

Multimedia

"Dân là gốc": Thước đo cao nhất của mọi quyết sách

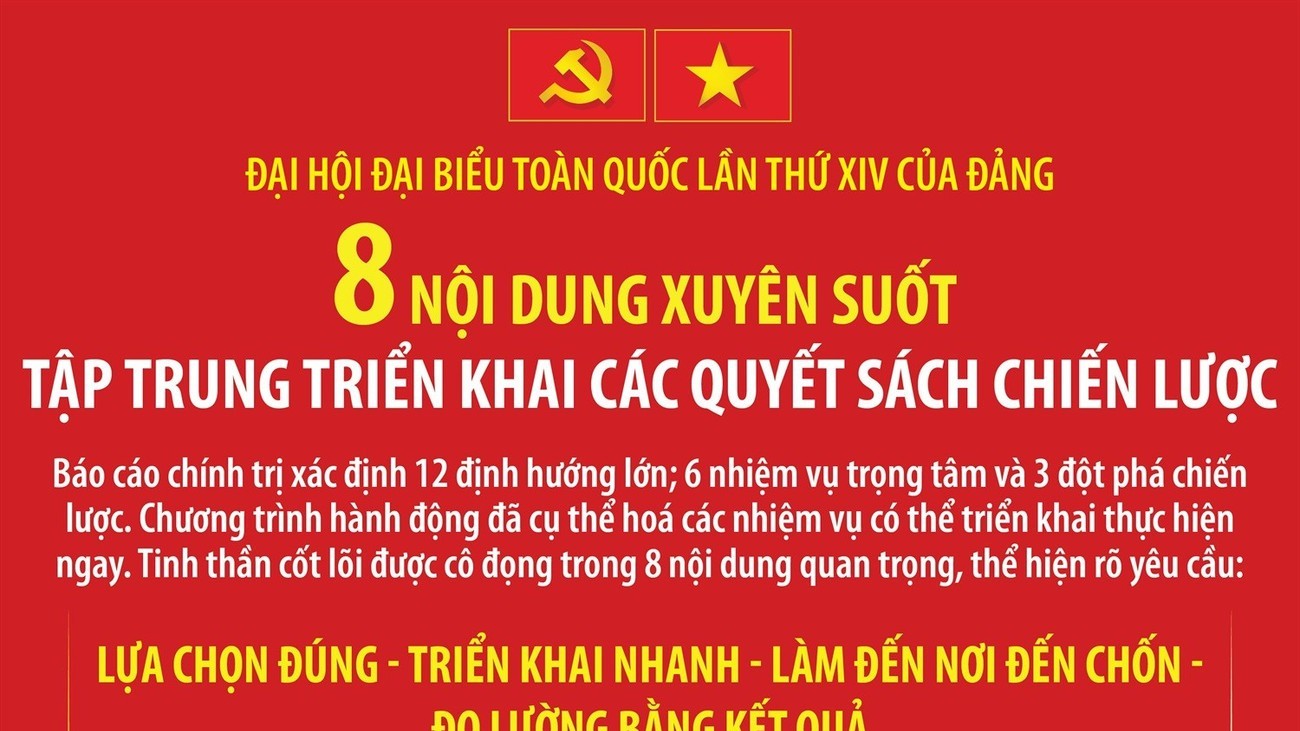

[Infographic] Đại hội Đảng XIV: 8 nội dung xuyên suốt triển khai các quyết sách chiến lược

[Infographic] Các mốc thời gian chính trong lịch trình bầu cử ĐBQH khóa XVI và đại biểu HĐND các cấp nhiệm kỳ 2026 – 2031

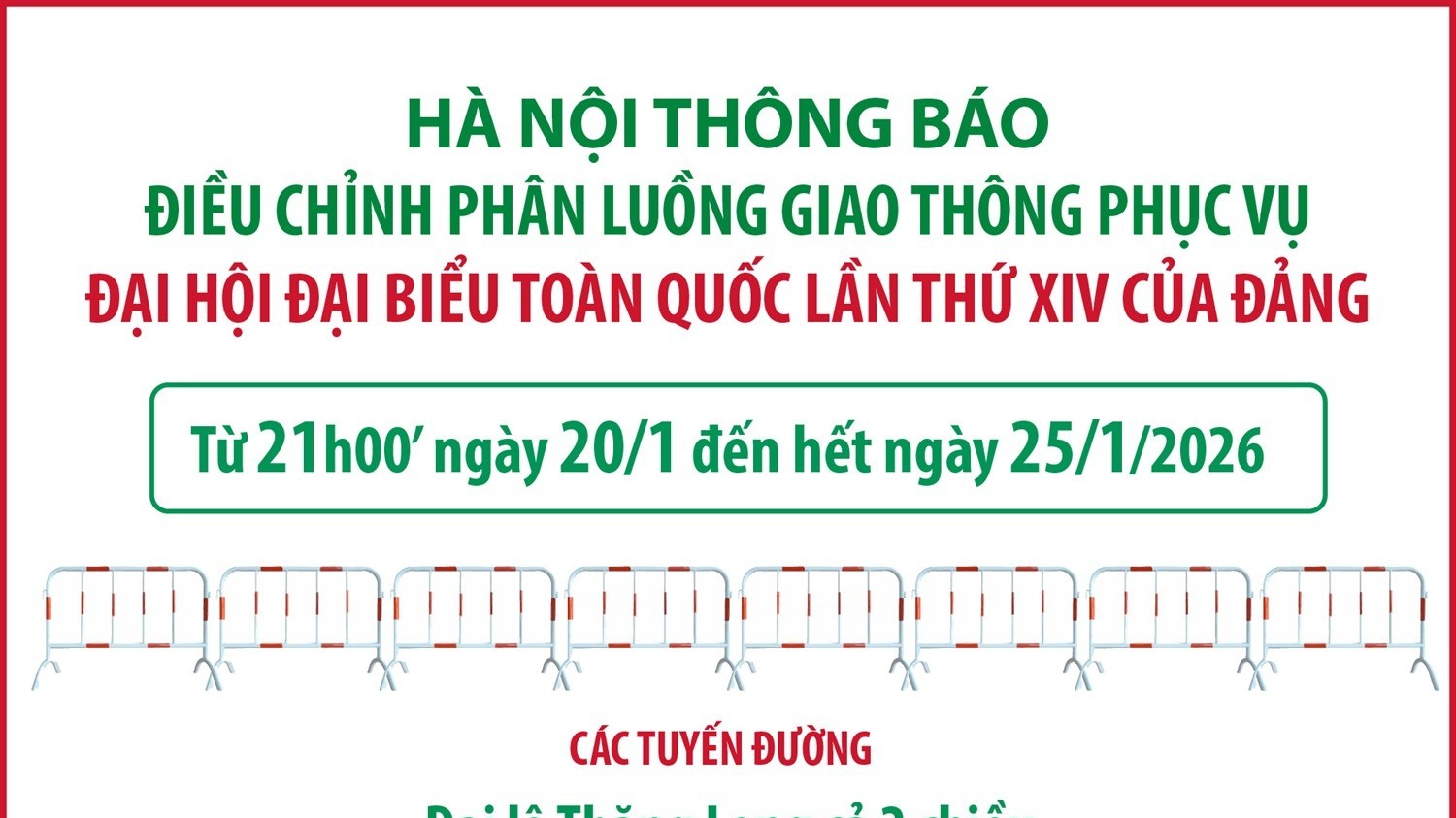

[Infographic] Hà Nội điều chỉnh phân luồng giao thông phục vụ Đại hội Đảng XIV

[Infographic] Một số nội dung quan trọng tại Đại hội XIV của Đảng

[Infographic] Nghị quyết 80- NQ/TW: 8 nhiệm vụ, giải pháp phát triển văn hóa Việt Nam

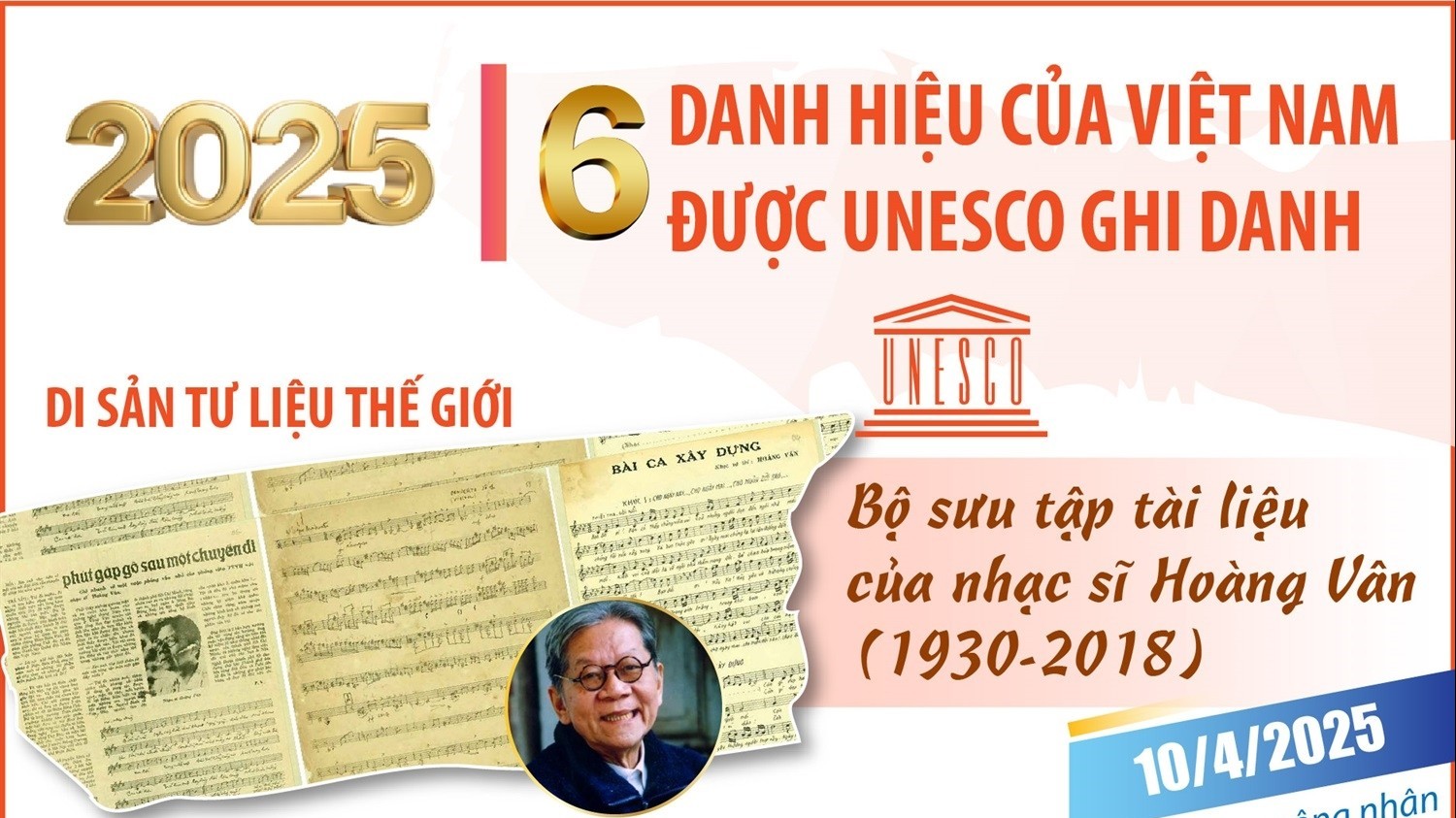

[Infographic] 6 danh hiệu của Việt Nam được UNESCO ghi danh năm 2025

Đại sứ Lào tại Việt Nam tin tưởng Đại hội XIV sẽ tạo động lực mạnh mẽ cho Việt Nam phát triển toàn diện

![[Video] Đại sứ Lào tại Việt Nam tin tưởng Đại hội XIV sẽ tạo động lực mạnh mẽ cho Việt Nam phát triển toàn diện](https://thoidai.com.vn/stores/news_dataimages/2026/012026/19/10/video-dai-su-lao-tai-viet-nam-tin-tuong-dai-hoi-xiv-se-tao-dong-luc-manh-me-cho-viet-nam-phat-trien-toan-dien-20260119100621.jpg?rt=20260119100624?260119015548)

[Video] Đại sứ Lào tại Việt Nam tin tưởng Đại hội XIV sẽ tạo động lực mạnh mẽ cho Việt Nam phát triển toàn diện

![[Video] WVIV thúc đẩy nông nghiệp tái sinh, nâng cao sinh kế cộng đồng tại Thanh Hóa](https://thoidai.com.vn/stores/news_dataimages/2026/012026/25/12/video-wviv-thuc-day-nong-nghiep-tai-sinh-nang-cao-sinh-ke-cong-dong-tai-thanh-hoa-20260125121019.jpg?rt=20260125121023?260126090118)

[Video] WVIV thúc đẩy nông nghiệp tái sinh, nâng cao sinh kế cộng đồng tại Thanh Hóa

![[Video] Plan International và Tỉnh Đoàn Quảng Trị xây dựng lực lượng thanh niên hành động vì khí hậu](https://thoidai.com.vn/stores/news_dataimages/2026/012026/25/12/plan-international-va-tinh-doan-quang-tri-xay-dung-luc-luong-thanh-nien-hanh-dong-vi-khi-hau-20260125120627.jpg?rt=20260125120631?260126090029)

[Video] Plan International và Tỉnh Đoàn Quảng Trị xây dựng lực lượng thanh niên hành động vì khí hậu

![[Video] 10 sự kiện văn hóa, thể thao và du lịch tiêu biểu năm 2025](https://thoidai.com.vn/stores/news_dataimages/anhvm/012026/06/17/10_SUYY_KIEYYN_VAYN_HOAY_THEYY_THAO_VAY_DU_LIYCH_TIEYU_BIEYYU_NAYM_2025_mp4_29_12_-_YouTube_11.jpg?260106064252)

[Video] 10 sự kiện văn hóa, thể thao và du lịch tiêu biểu năm 2025

Plan International Việt Nam hỗ trợ khẩn cấp hơn 1,8 tỷ đồng cho người dân Đà Nẵng sau bão

Vietnam Happy Fest 2025: Lan tỏa những giá trị hạnh phúc giữa lòng Hà Nội

![[VIDEO] Tổ chức Cứu trợ Trẻ em tiếp sức trẻ em Bắc Ninh sớm quay về nhịp sống sau thiên tai](https://thoidai.com.vn/stores/news_dataimages/2025/122025/06/13/croped/cu-u-tro-bn-2-cover20251206131142.jpg?251206015430)

[VIDEO] Tổ chức Cứu trợ Trẻ em tiếp sức trẻ em Bắc Ninh sớm quay về nhịp sống sau thiên tai

![[Video] World Vision hỗ trợ hơn 1.100 người dân Quảng Ngãi tiếp cận nước sạch bền vững](https://thoidai.com.vn/stores/news_dataimages/2025/112025/25/09/dong-tam-doc-suc-cuu-tro-dong-bao-vung-lu-20251125093203.jpg?rt=20251125093457?251125104340)

[Video] World Vision hỗ trợ hơn 1.100 người dân Quảng Ngãi tiếp cận nước sạch bền vững

![[Video] Đồng tâm, dốc sức cứu trợ đồng bào vùng lũ](https://thoidai.com.vn/stores/news_dataimages/2025/112025/25/09/dong-tam-doc-suc-cuu-tro-dong-bao-vung-lu-20251125093208.jpg?rt=20251125093211?251125103933)

[Video] Đồng tâm, dốc sức cứu trợ đồng bào vùng lũ

![[Video] Ấn Độ tặng Giải thưởng Hòa bình Romesh Chandra cho bà Nguyễn Thị Bình](https://thoidai.com.vn/stores/news_dataimages/2025/112025/18/18/croped/ba-bi-nh-cover20251118184907.jpg?251119023755)

[Video] Ấn Độ tặng Giải thưởng Hòa bình Romesh Chandra cho bà Nguyễn Thị Bình

![[Video] Lễ dâng y Kathina tại Đà Nẵng: Sợi dây gắn kết Phật giáo các nước châu Á](https://thoidai.com.vn/stores/news_dataimages/anhvm/102025/15/11/Kathina__1.jpg?251015023951)

[Video] Lễ dâng y Kathina tại Đà Nẵng: Sợi dây gắn kết Phật giáo các nước châu Á

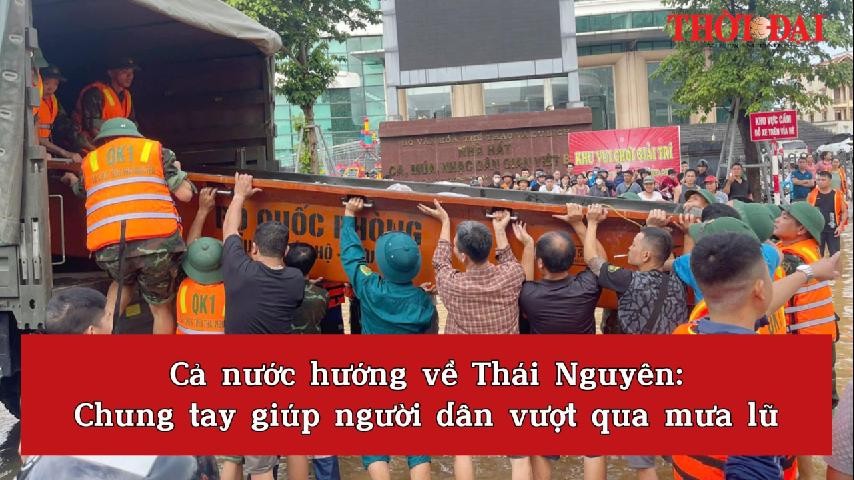

Cả nước hướng về Thái Nguyên: Chung tay giúp người dân vượt qua mưa lũ

Trailer lễ hội Văn hóa Thế giới tại Hà Nội lần thứ nhất

![[Video] Không khí rộn ràng ngày khai giảng năm học mới trên cả nước](https://thoidai.com.vn/stores/news_dataimages/2025/092025/05/15/video-khong-khi-ron-rang-ngay-khai-giang-nam-hoc-moi-tren-ca-nuoc-20250905155537.jpg?rt=20250905155544?250905065119)

[Video] Không khí rộn ràng ngày khai giảng năm học mới trên cả nước

![[Video] Petr Tsvetov: Việt Nam ấm áp và thân thuộc](https://thoidai.com.vn/stores/news_dataimages/2025/092025/01/22/video-petr-tsvetov-viet-nam-am-ap-va-than-thuoc-20250901222230.jpg?rt=20250901222235?250902094525)